[VCD] vGPU Policies

Sur Cloud Director il est possible lorsque vous avez des hôtes avec des cartes GPU dédiées de configurer des « vGPU Policies » qui vont permettre de créer des workloads pour consommer ces GPUs.

Environnements :

- 6 * VxRail V670F avec deux A40 par serveur et 1To RAM répartie sur deux Availability Zone

- Cloud Director 10.3.3.4

N.B : La gestion des workloads GPU est apparue avec vCD 10.3.2

1. Définir ses vGPU Policies et les limites qu’elles imposent

Avec des workloads GPU le provisionning n’est plus le même qu’avec des workloads traditionnels car les workloads GPU ne supportent pas la surallocation de vRAM.

Exemple :

« Les modèles de cartes NVIDIA A40 ont 48GB RAM (*2 par serveur) il est donc possible de provisionner jusqu’à 96GB maximum par serveur, là où des workloads traditionnels auraient pu en provisionner plus grâce à la surallocation. »

Partant de ce principe il faut définir ses vGPU policies de manière à ne pouvoir provisionner que ce dont le cluster est capable.

Le second point qui est également primordial lorsque nous parlons de workloads GPU est que lorsqu’un profil est mappé sur une carte il réserve cette carte pour ce type de profil.

Exemple :

« Vous mettez en place un profil qui va consommer 2GB de RAM sur la carte NVIDIA A40, ce profil va donc réserver la carte où seul d’autres profils de même type (consommant également 2GB de RAM) pourront être hébergés. »

Cette limitation est assez imposante car sur un cluster de 6 nœuds il est théoriquement possible de seulement faire tourner 6 profils maximums si nous prenons en compte la redondance.

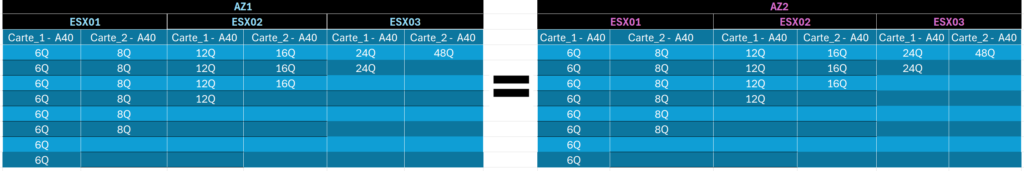

Une image vaut mille mots (chaque carte porte 48GB maximum) :

1.1 Cas concret de profils disponibles

Comme précisé en début d’article l’environnement sur lequel j’effectue les configurations sont 3 nœuds VxRail V670F sur une AZ 1, et 3 nœuds sur une autre AZ.

Ce qui me donne :

- 3To RAM par AZ

- 96GB vRAM par serveur

- 6 profils vGPU maximums

N.B : La nomenclature ci-dessous est un exemple, mais elle se répartit de la manière suivante :

A40 => modèle de carte

4Q => Profil vGPU

1vGPU => utilisation d’un vGPU par VM

c.micro => gabarit CPU/RAM

N.B : Ne pas prendre en compte le profil « a40-4q-1vGPU-c.5xlarge » pour lequel il s’agit simplement d’une indication. Aucune perte de performance vNUMA n’a été démontrée sur vSphere 7.X

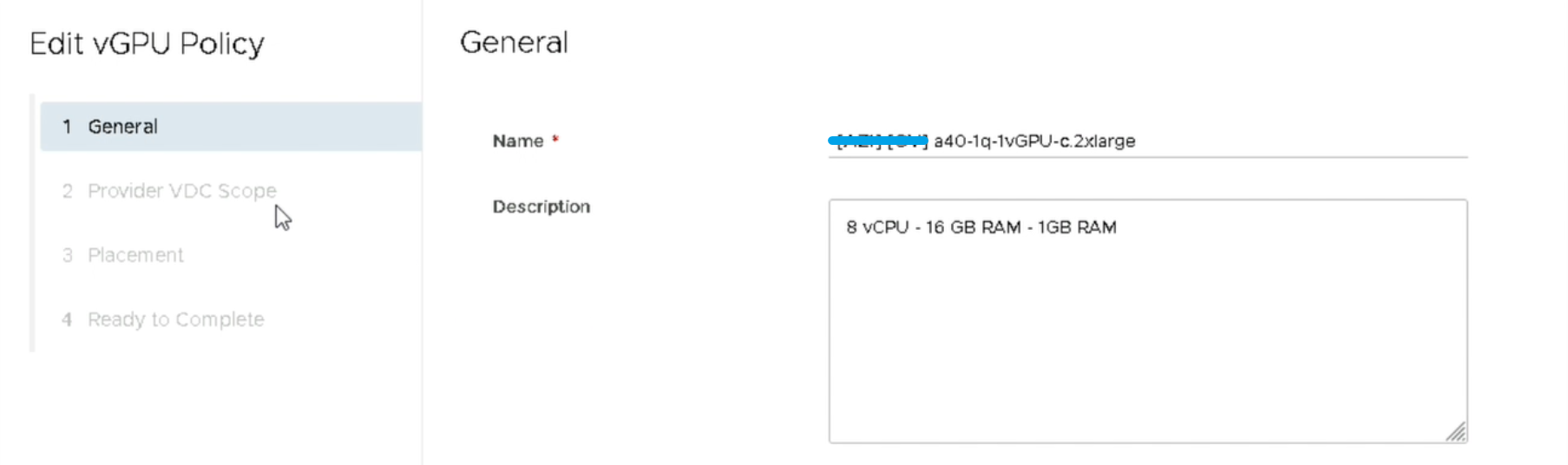

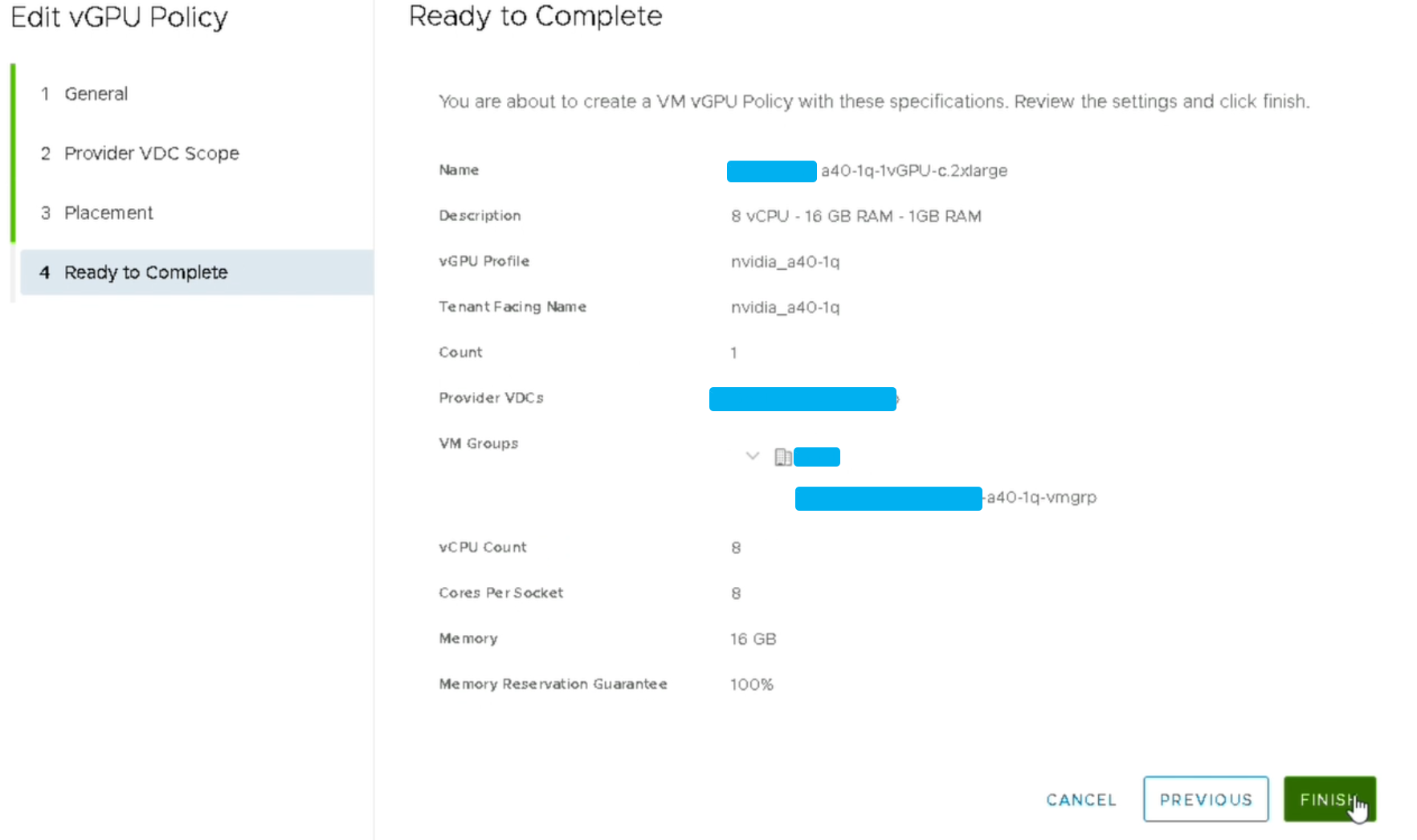

2. Création du profil vGPU sur vCD

Pour créer les vGPU Policies vous avez 2 chemins pour le faire, soit via le PVDC soit directement depuis la vue Cloud Resources

PVDC > NOM_DE_VOTRE_PVDC > vGPU > NEW

ou

Cloud Resources > vGPU > NEW

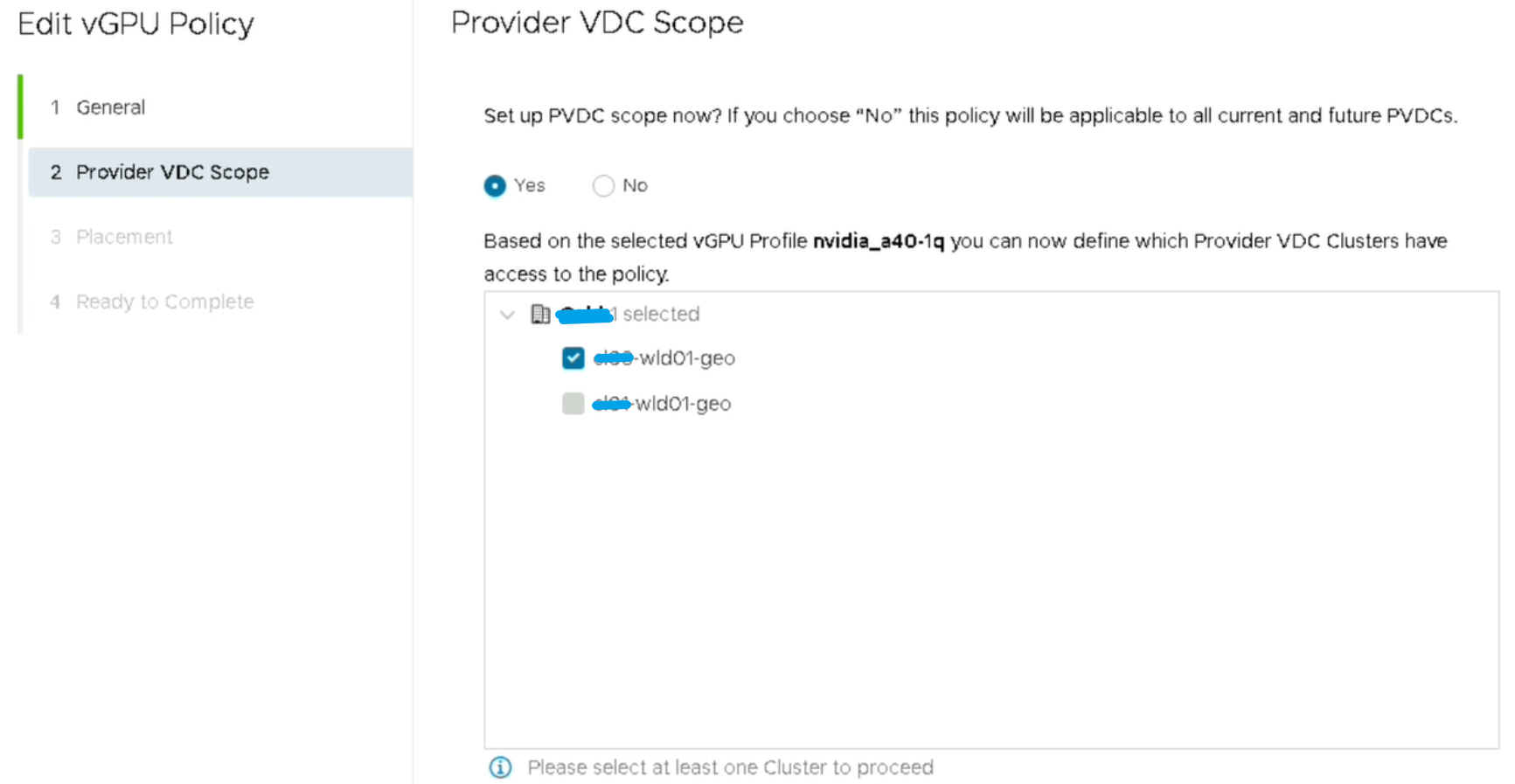

Puis sélectionner le cluster

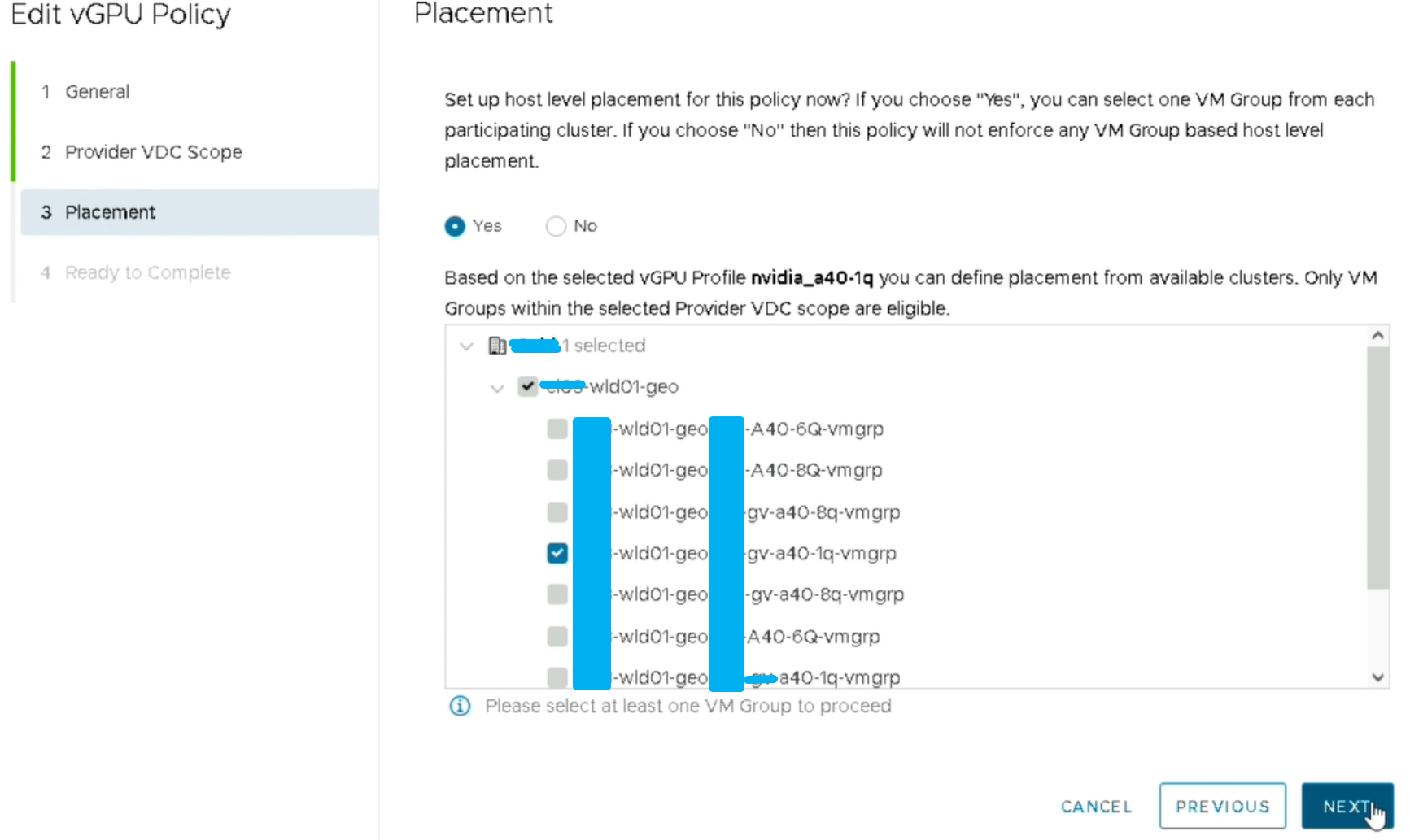

A cette étape il faut choisir le « vmgroup » côté vCenter qui va porter l’ensemble des VMs du même type

Une fois toute ces étapes terminées vous n’avez plus qu’à mapper vos vGPU Policies sur vos OrgVDC.

No responses yet